论文阅读 Feedback-Aware Double

Title: Feedback-Aware Double COntrolling Network for Emotional Support Conversation

论文速览

Abstract

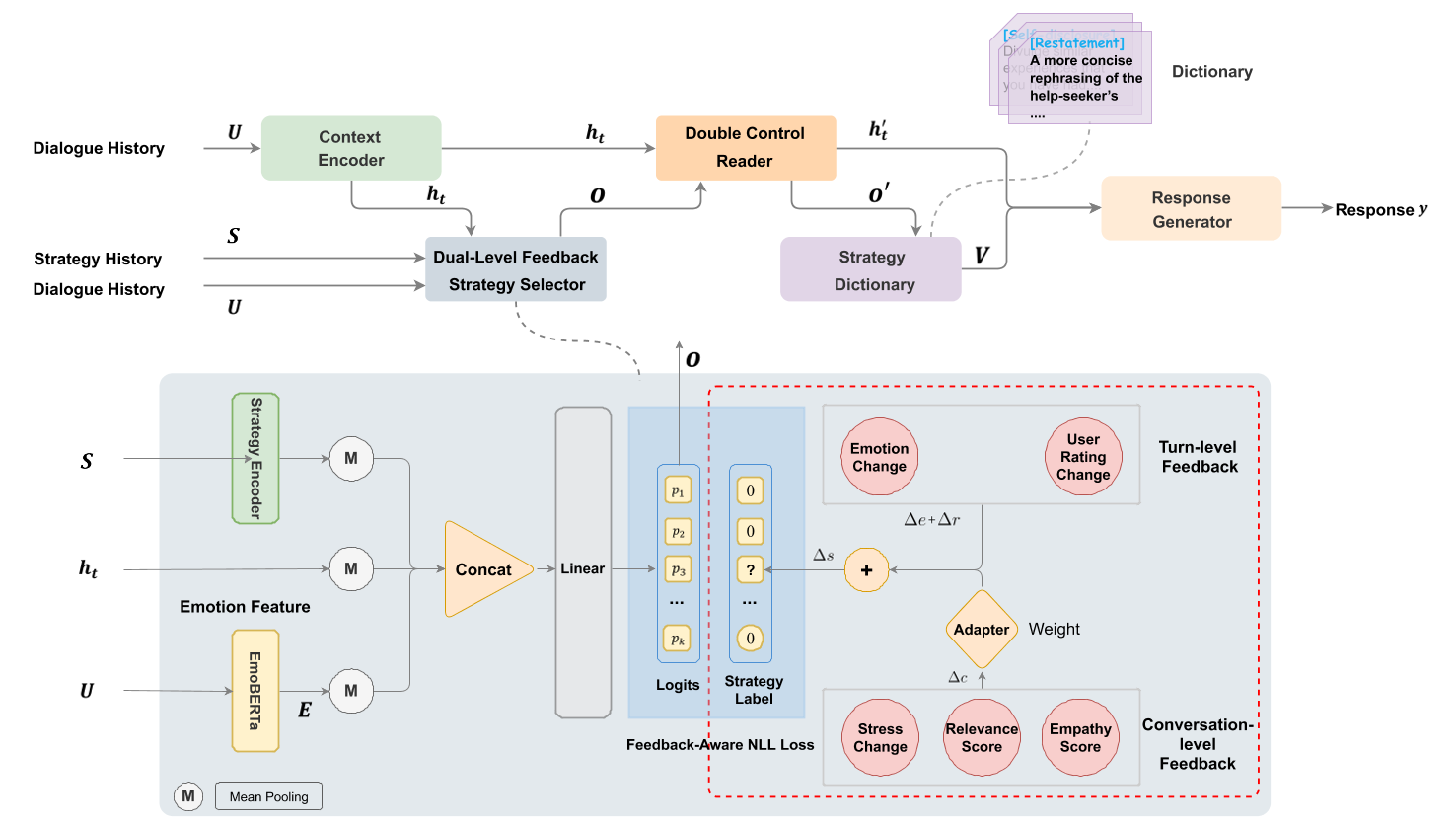

双层反馈策略选择器:通过反馈信息预测策略

双层控制阅读器:通过策略约束上下文响应

策略词典:丰富策略的语义信息 ## Introduction ## Related Work ## Problem Formulation ## Approach

上下文编码器

- BlenderBot预训练编码器编码上下文历史对话U,得到Ht

双层反馈策略选择器

- 策略选择

- 输入

- BlenderBot Encoder 编码上下文历史对话U,得到隐状态Ht

- BlenderBot Encoder 编码策略S

- EmoBERTa Encoder 编码上下文对话U

- 公式

- 上下文编码器(策略S同理):\[\boldsymbol{H}=\operatorname{Enc}_{cxt}\left(\boldsymbol{[CLS]},

\boldsymbol{u}_{1}, \boldsymbol{[SEP]}, \boldsymbol{u}_{2}, ...,

\boldsymbol{u}_{M}\right)\],M为对话数

- \[\boldsymbol{H}=\left(\boldsymbol{u}_{1},..., \boldsymbol{u}_{T}\right)\],T为Token数

- 情感编码器:\[\boldsymbol{E}=\operatorname{EmoBERTa}\left(\boldsymbol{[CLS]},

\boldsymbol{u}_{1}, \boldsymbol{[SEP]}, \boldsymbol{u}_{2}, ...,

\boldsymbol{u}_{M}\right)\],M为对话数

- \[\boldsymbol{E}=\left(\boldsymbol{e}_{1},..., \boldsymbol{e}_{T}\right)\],T为Token数

- 分类:\[\boldsymbol{o}=\operatorname{MLP}\left(\tanh

\left(\boldsymbol{W}_{o}^{T}[\boldsymbol{s} ; \boldsymbol{c} ;

\boldsymbol{r}]+\boldsymbol{b}_{\boldsymbol{o}}\right)\right)\]

- s、c、r 为策略S、上下文H、情感分类E。编码+平均池化操作后得到

- 上下文编码器(策略S同理):\[\boldsymbol{H}=\operatorname{Enc}_{cxt}\left(\boldsymbol{[CLS]},

\boldsymbol{u}_{1}, \boldsymbol{[SEP]}, \boldsymbol{u}_{2}, ...,

\boldsymbol{u}_{M}\right)\],M为对话数

- 输入

- 双层反馈

- 回合级反馈:局部变量,当前用户的感受。包含每轮对话Seeker情感Δe和Seeker评分变化Δr

- 对话级反馈:全局变量Δc,用户的全局状态。包含Seeker在谈话后的情绪压力、Supporter对话题的回应的相关性、Supporter对Seeker感受的理解和共情

- 融合adapter:整合回合级和会话级反馈的两类语义信息。Δs = Δe + Δr + uΔc【计算损失时,给予正向或负向的反馈】

- 策略选择

双控读取器(模仿情感聊天机器ECM)

- context-to-strategy:利用上下文信息来选择上下文相关的策略

- \[\boldsymbol{g}^{c} = \operatorname{sigmoid}\left( \boldsymbol{W}_{c}^{T} \boldsymbol{c} + \boldsymbol{b}_{c} \right)\]

- strategy-to-context:编码阶段可以关注与策略相关的上下文,从而生成策略约束的响应

- \[\boldsymbol{g}^{o} = \operatorname{sigmoid}\left( \boldsymbol{W}_{o}^{T} \boldsymbol{o} + \boldsymbol{b}_{o} \right)\]

- 残差连接:在原始信息和更新信息之间进行权衡

- \[\begin{array}{r} o^{\prime}=(1-\beta) \cdot o+\beta \cdot g^{c} \otimes o \\ h_{t}^{\prime}=(1-\alpha) \cdot h_{t}+\alpha \cdot g^{o} \otimes h_{t} \end{array}\]

- context-to-strategy:利用上下文信息来选择上下文相关的策略

策略字典

- 输入策略令牌的描述, 而不是策略令牌,以便模型对策略进行更深入的理解

- Encoder-Decoder 之间的状态传输类似于MISC,采用cross-attention代替self-attentionMISC: A MIxed Strategy-Aware Model Integrating COMET for Emotional Support Conversation

响应生成

- BlenderBot Decoder:\[\boldsymbol{p}\left(y_{z} \mid \boldsymbol{y}_{<z}, \boldsymbol{h}_{\boldsymbol{t}}^{\prime}, \boldsymbol{V}\right)=\text { Generator }\left(\boldsymbol{W}_{y<z}, \boldsymbol{h}_{\boldsymbol{t}}^{\prime}, \boldsymbol{V}\right)\]

联合训练

- 策略预测:反馈感知负对数似然 feedback-aware negative log-likelihood

- \[\mathcal{L}_{1}=\left\{\begin{array}{ccc} -\hat{o} \log \left(\operatorname{softmax}\left(\boldsymbol{o}^{\prime}\right)\right) & \text { if } & \Delta s>0 \\ -\hat{o} \log \left(1-\operatorname{softmax}\left(\boldsymbol{o}^{\prime}\right)\right) & \text { if } & \Delta s \leq 0 \end{array}\right.\\\]

- 响应生成:标准交叉熵损失优化 cross-entropy

- \[\mathcal{L}_{2}=-\sum_{z=1}^{Z} \log \boldsymbol{p}\left(y_{z} \mid \boldsymbol{y}_{<z}, \boldsymbol{h}_{\boldsymbol{t}}^{\prime}, \boldsymbol{V}\right)\] ## Experiment

- 策略预测:反馈感知负对数似然 feedback-aware negative log-likelihood

采用EmoBERTa-base作为特征提取器,以获取Seeker的情感得分和情感表征,情感得分由softmax函数使用EmoBERTa-base的[CLS]表示获得 ## Experimental Results ## Analyses ## conclusion # 关注的问题

预测策略只依靠对话历史,而不考虑求助者反馈,导致预测的结果与用户无关

建模过程只关注上下文到策略,而不关注策略到上下文和与策略相关的上下文 # 解决方法

双层反馈策略选择器:利用回合级和会话级反馈信息来激励或惩罚策略

双层控制阅读器:策略到上下文流来生成策略约束响应 # 创新点 / 本文的优势